Imagem gerada por inteligência artificial mostra a escultura O Pensador,de Auguste Rodin,retratada como um robô — Foto: Dall-E

Imagem gerada por inteligência artificial mostra a escultura O Pensador,de Auguste Rodin,retratada como um robô — Foto: Dall-E

GERADO EM: 30/07/2024 - 04:01

O Irineu é a iniciativa do GLOBO para oferecer aplicações de inteligência artificial aos leitores. Toda a produção de conteúdo com o uso do Irineu é supervisionada por jornalistas.

LEIA AQUI

Dois novos estudos indicam que modelos de inteligência artificial como o ChatGPT deverão enfrentar dificuldade crescente para se aprimorar a partir de agora. Um deles mostra que essa IA incorporou a propensão de humanos a cair em "pegadinhas" lógicas. O outro mostra que robôs treinados com textos criados por robôs entram em colapso.

Delírio robótico: Cientistas criam método para detectar 'alucinação' de inteligência artificialiPhones por R$ 1.089: prazo para participar de leilão da Receita Federal com eletrônicos e carros acaba hoje; veja como

O primeiro trabalho,feito por um grupo de cientistas da DeepMind,a divisão de pesquisa em IA do Google,teve como objetivo entender se os grandes modelos de linguagem (LLM),os projetos que possuem a mesma arquitetura do ChatGPT,Gemini e Llama estão incorporando problemas de raciocínio típicos de humanos.

Isso era de certa forma esperado,porque esses projetos foram todos treinados com um grande volume de textos produzidos por humanos,mas o grupo,liderado pelo cientista da computação Andrew Lampinen,mostra que o problema vai além da presença de erros factuais no material incorporado: os LLMs estão aprendendo a raciocinar de maneira errada em algumas instâncias.

Tecnologia e arte: IA turbina criatividade individual na escrita,mas reduz diversidade coletiva de ideias

O problema,dizem os pesquisadores,é que os modelos acabam incorporando uma preconcepção sobre alguns assuntos,e não conseguem construir um argumento novo mesmo quando são alimentados com informações diferentes.

Para ilustrar isso,os cientistas submeteram o GPT-3 e alguns outros modelos à tarefa de avaliar se uma cadeia de raciocínio estava correta. Um exemplo é a afirmação abaixo:

Todos os estudantes leem.

Algumas pessoas que leem também escrevem ensaios.

Logo,alguns estudantes escrevem ensaios.

Mais de 90% das pessoas que leem essa sequencia de afirmações afirmam que ela é válida como raciocínio. Mas não é. Saber que algumas pessoas que leem escrevem contos não implica que essas mesmas pessoas sejam também estudantes.

Entretanto,como no mundo real sabemos que alguns estudantes escrevem contos,deixamos que nosso conhecimento prévio interfira na nossa avaliação sobre a validade do raciocínio.

Tecnologia: Nvidia lança software e serviços para impulsionar a rápida adoção da IA pelas empresas

Isso é o que psicólogos chamam de "efeito de conteúdo",porque o significado contido nas palavras usadas na conclusão interfere em nossa cadeia de pensamento. Neste caso isso não é um problema muito grande,porque sabemos que estudantes escrevem redações. Mas quando máquinas cometem esse tipo de equívoco,é um sinal de que a IA não está conseguindo raciocinar de forma fria,como se esperaria dela.

Em um artigo na revista científica PNAS Nexus,Lampinen e colegas realizaram experimento pedindo ao sistema de IA para avaliar o raciocínio acima,além de outos similares,e o modelo errou com frequência,afetado pelo "efeito de conteúdo". Mas mesmo quando o conteúdo era substituído por variáveis abstratas,o erro de raciocínio ocorria:

Todos os X são Y.

Alguns Y são Z.

Logo,alguns X são Z.

Assim como os humanos,os modelos de IA identificavam com mais facilidade o erro de raciocínio neste caso,em comparação ao exemplo anterior,mas ainda assim falhavam em algumas circunstâncias.

"Os humanos são pensadores imperfeitos. Nós raciocinamos mais efetivamente sobre situações consistentes com nossa compreensão de mundo,e frequentemente lutamos para raciocinar em situações que violam essa compreensão ou são abstratas e desconectadas do mundo real",afirmou Lampinen no estudo. "Nossos experimentos mostram que os modelos de linguagem espelham esses padrões de comportamento."

1 de 12

O que foi informado ao sistema: imagem hiper-realista retrata um homem tirando uma selfie com os amigos em um cinema lotado. As pessoas assistem a uma comédia e riem muito — Foto: Imagem gerada por Midjourney

2 de 12

No cinema. A figura que segura o celular tem as mãos deformadas — Foto: Imagem gerada por IA/Midjourney

Pular

X de 12

Publicidade 12 fotos

3 de 12

Harmonia: Um maestro conduz uma orquestra,rege com energia,a câmera está de costas para o maestro,os músicos estão de frente para a câmera,ele toca a Nona Sinfonia de Beethoven - Foto: imagem gerada por IA/Midjourney

4 de 12

Regência. A imagem exibe mão direita do maestro com dedo alongado. E a batuta se assemelha a um arco de violino — Foto: Imagem gerada por IA/Midjourney

Pular

X de 12

Publicidade

5 de 12

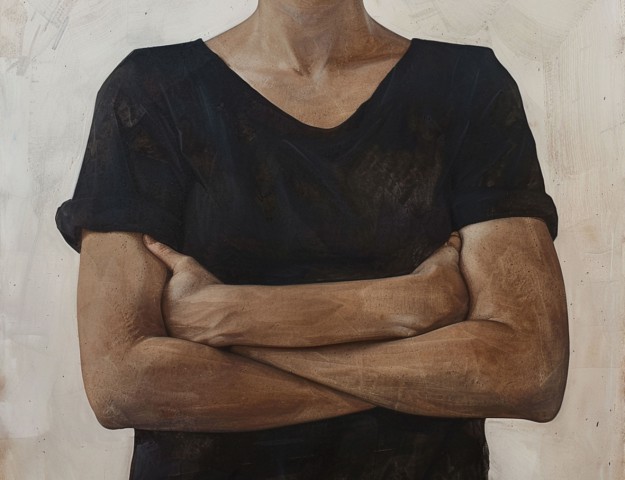

O que foi informado ao sistema de inteligência artificial: imagem exibe uma pessoa com os braços cruzados,não foi solicitado que aparecesse o rosto - foto: imagem criada por IA/Midjourney

6 de 12

Em excesso. Imagem gerada por inteligência artificial mostra uma pessoa com mais um braço — Foto: Imagem gerada por IA/Midjourney

Pular

X de 12

Publicidade

7 de 12

Alegria: Uma criança sorri imensamente feliz e até grita de boca aberta de tanta felicidade quando recebe um presente. Esta imagem serve como uma prova do poder da felicidade — Foto: Imagem gerada por IA/Midjourney

8 de 12

Sorriso assustador. O dente da criança que recebe o presente se confunde com a gengiva — Foto: Imagem gerada por IA/Midjourney

Pular

X de 12

Publicidade

9 de 12

Dueto inusitado: Produção exibe a cantora brasileira Anitta cantando com o líder do Coldplay,Crhis Martin,dançando e cantando no palco,com luz de neon — Foto: Imagem gerada por IA/Midjourney

10 de 12

Atenção ao vocalista. A mão direita do cantor Chris Martin aparece com seis dedos — Foto: Imagem gerada por IA/Midjourney

Pular

X de 12

Publicidade

11 de 12

Apreciando a vista. Um grupo de capivaras com a cidade do Rio de Janeiro ao fundo,em um dia de garoa,imagem no estilo de publicações voltadas para a vida animal — Foto: Imagem gerada por IA/Midjourney

12 de 12

É esse animal mesmo? Capivara aparece de rabo e mais parece um rato — Foto: Imagem gerada por IA/Midjourney

Pular

X de 12

Publicidade Os erros da IA

Essa fragilidade deriva não só da busca da IA de imitar humanos,mas também da maneira com que as LLMs foram concebidas. Todos esses projetos alimentados com quantidades enormes de informações escritas têm uma maneira "probabilística" de raciocinar.

Quando um LLM produz resposta para uma pergunta,ele parte do texto digitado pelo usuário e usa o seu banco de dados de treinamento para tentar prever quais palavras são mais prováveis aparecer após aquela sequência de texto. Palavra por palavra,o sistema de IA vai produzindo a resposta buscando o resultado mais provável de aparecer após a pergunta.

A IA não é capaz,porém,de saber quando deve abandonar esse raciocínio probabilístico para começar a operar de modo sistemático com lógica formal. Nessas ocasiões,é como se o sistema tentasse resolver a conta "2 + 2" por votação,consultando sua base de dados,em vez de operar a soma como uma calculadora.

Se os humanos estão contaminando a base de raciocínio da IA com raciocínio equivocado,um outro tipo de contaminação (esta outra digital),também ameaça a confiabilidade de futuros projetos de inteligência artificial.

Um segundo estudo,publicado nesta semana na revista Nature por cientistas da Universidade de Oxford,simula o que acontecerá com a IA treinada com dados buscados na internet quando uma porcentagem grande desses dados não tiver mais origem humana.

1 de 14

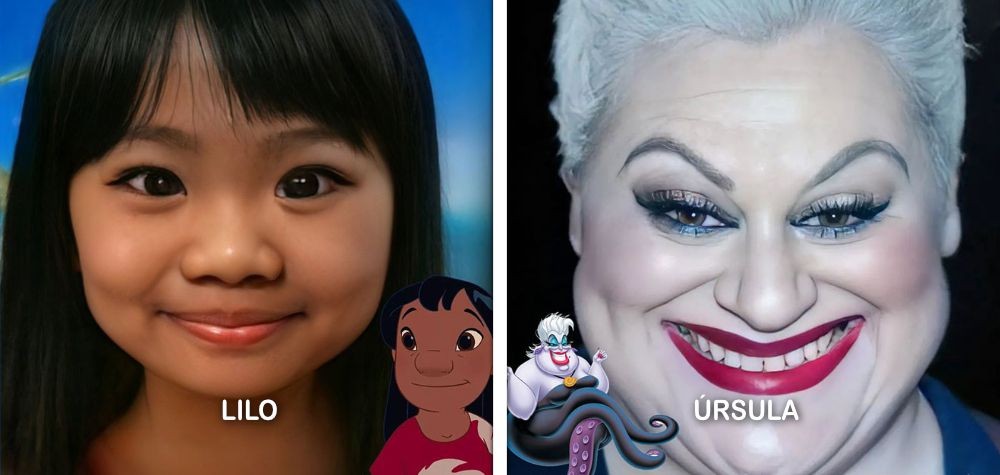

Paulista Hidreley Dião usa Photoshop e inteligência artificial para 'dar vida' a personagens icônicos — Foto: Reprodução/Instagram

2 de 14

Assim seria o Snoopy em sua vida real,de acordo com a IA — Foto: Copilot

Pular

X de 14

Publicidade 14 fotos

3 de 14

Homer e Marge Simpson,na criação de Hidreley Dião — Foto: Reprodução/Instagram

4 de 14

Moe,dono do bar frequentado por Homer Simpson,na criação de Hidreley Dião — Foto: Reprodução/Instagram

Pular

X de 14

Publicidade

5 de 14

Princesa Aurora,mais conhecida como Bela Adormecida,segundo ferramenta de Inteligência Artificial — Foto: Reprodução/La Nacion

6 de 14

Na quarta imagem,Shrek parece diferente de todas as outras imagens por ter cabelos grisalhos e barba — Foto: Copilot

Pular

X de 14

Publicidade

7 de 14

Esta é a aparência de Shrek e Burro na vida real,de acordo com o Copilot — Foto: Copilot

8 de 14

Paulista Hidreley Dião usa Photoshop e inteligência artificial para 'dar vida' a personagens icônicos — Foto: Reprodução/Instagram

Pular

X de 14

Publicidade

9 de 14

Paulista Hidreley Dião usa Photoshop e inteligência artificial para 'dar vida' a personagens icônicos — Foto: Reprodução/Instagram

10 de 14

Paulista Hidreley Dião usa Photoshop e inteligência artificial para 'dar vida' a personagens icônicos — Foto: Reprodução/Instagram

Pular

X de 14

Publicidade

11 de 14

Esta é a aparência de Johnny Bravo na vida real,segundo Copilot — Foto: Co-piloto

12 de 14

Esta é a aparência de Johnny Bravo na vida real,segundo Copilot — Foto: Co-piloto

Pular

X de 14

Publicidade

13 de 14

Bob Esponja na "vida real" — Foto: Copilot

14 de 14

Garfield — Foto: Copilot

Pular

X de 14

Publicidade

A quantidade de conteúdo gerada por IA,afinal de contas,está crescendo cada vez mais,e já representa uma parte maior daquilo que existe na web. Esse fenômeno estabelece um processo de loop em que,para alguns tópicos,a IA começa a usar informações que ela mesma produziu para tentar se aprimorar.

Liderado pelo cientista Ilia Shumailov,o grupo de Oxford fez uma simulação criando pequenos modelos de LLM para entender o que acontece quando esse processo se repete por sucessivas gerações (uma IA treinada com dados produzidos por IA,que foi treinada com dados produzidos por outra IA,e assim por diante).

Os pesquisadores mostraram que,quando o conteúdo na web sobre um assunto começa a ser dominado por produção de LLMs,os modelos de IA entram em colapso ao tentar discorrer sobre o tema. O sistema passa a gerar frases sem sentido e sequências arbitrárias de palavras repetidas.

"Os LLMs chegaram para ficar e mudarão substancialmente o ecossistema de texto e imagens online. Nós descobrimos que o uso indiscriminado de conteúdo gerado por esses modelos para treinamento de IA causa defeitos irreversíveis nos modelos resultantes",diz Shumailov na Nature.

Segundo o cientista,esse problema precisa ser atacado pela indústria de tecnologia para que a inteligência artificial consiga dar seu próximo salto de inovação.

"Isso precisa ser levado a sério se quisermos manter os benefícios que a IA obtém com treinamento a partir de dados extraídos da web em grande escala. O valor de dados gerados por interações humanas genuínas será cada vez maior na presença de conteúdo gerado por LLMs em dados capturados da Internet."

Webstories

© Hotspots da moda portuguesa política de Privacidade Contate-nos